DeepSeek cuestiona el futuro de Nvidia y de las inversiones en IA

Miguel Ángel Valero

Los fundadores de Buy & Hold, Julián Pascual y Rafael Valera, no se atreven a afirmar que exista una burbuja entre las tecnológicas de EEUU, pero sí afirman que "no nos compensa la relación riesgo/rentabilidad, y sus acciones están muy caras".

La china DeepSeek ha creado un sistema de lenguaje artificial que ya aparece entre los primeros en las plataformas de descargas de EEUU, "lo que indica que goza de una calidad similar a los grandes sistemas de Open AI o de Meta", a un precio supuestamente un 96% inferior al servicio de pago de las estadounidenses. Aunque los expertos de Buy & Hold avisan que "hay mucha información contradictoria sobre el coste real" de la firma china.

Pero estos expertos también tienen claro que "DeepSeek lanza muchos interrogantes sobre la facturación a medio plazo y la sostenibilidad de Nvidia". "Está claro que mejoras en eficiencia se traducen en mayor uso, en un mayor nivel de aplicaciones basadas en IA y, por tanto, en mayores volúmenes de ventas de unidades de procesamiento gráfico (GPU) en el futuro, pero ¿a qué precio?", argumentan.

Según el consenso de Bloomberg, las ventas estimadas de Nvidia en 2025 son de 196.000 millones$, con un margen operativo del 64%. Además, hay que añadir las inversiones en inmuebles, centros de generación eléctrica, conexiones, cableado.

Las inversiones globales en IA superan los 500.000 millones$ este año, equivalente a la mitad del PIB español. "¿Es posible obtener en el futuro buenos retornos sobre el capital cuando se invierten estas cantidades ingentes de dinero y, sobre todo, cuando DeepSeek ha 'demostrado' que se puede hacer todo de un modo mucho más barato?", se preguntan los expertos de Buy & Hold.

Además, dos años después del modelo de lenguaje de Open AI, "no existen aplicaciones por las que los usuarios estén dispuestos a pagar dinero de verdad que pueda justificar las inversiones que se están haciendo". "Y, si los precios unitarios de los GPU de Nvidia se minoran en línea con los nuevos sistemas de DeepSeek, ¿qué pasaría con la facturación y los márgenes del gigante norteamericano, por mucho que aumentasen los volúmenes de venta?".

Conclusión de Buy & Hold: "vemos demasiados riesgos para invertir en una empresa cíclica., que no está precisamente barata (con un PER 30 para 2025) y que ha multiplicado su capitalización bursátil por 10 en los últimos tres años".

Payden & Rygel: la deflación del coste de la IA comenzó en 2012

La semana pasada, las noticias sacudieron los mercados al revelar que DeepSeek R1, un modelo de lenguaje extenso (LLM por sus siglas en inglés, Large Language Model) creado por un fondo de cobertura chino, tiene un rendimiento similar al de los LLM de vanguardia actuales, pero se entrenó a una fracción del coste.

De esta manera, generar inteligencia artificial puede costar menos y requerir menos unidades de procesamiento gráfico (GPU por sus siglas en inglés, Graphic Processing Units) de gama alta, así como menos electricidad que el resto, y a medida que la inteligencia artificial se abarata, se genera un bucle de retroalimentación positiva con cada vez más usos e inversiones posibles por parte de los consumidores.

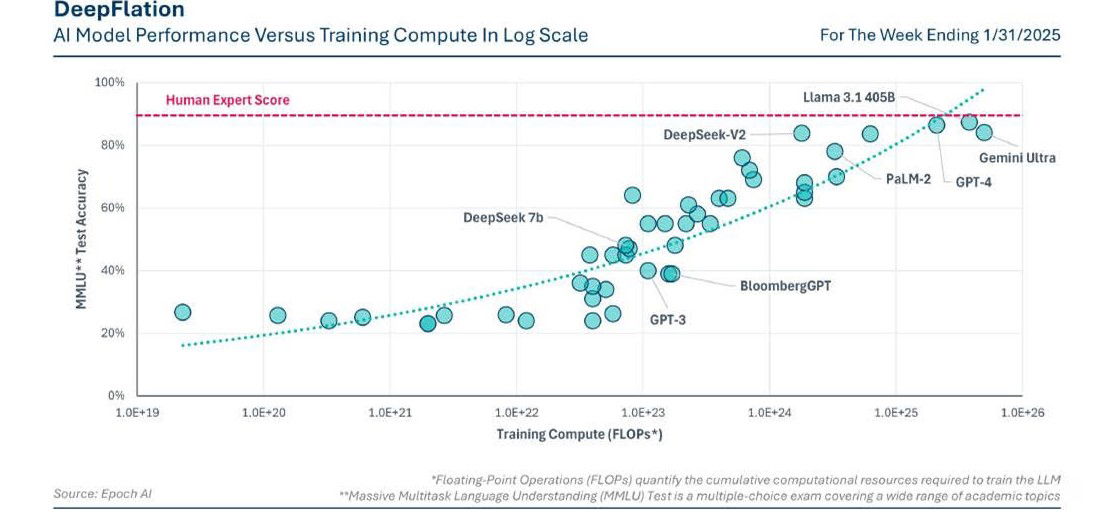

De hecho, la deflación del coste de la inteligencia artificial para LLM ya está en marcha, y los requisitos informáticos necesarios para alcanzar un nivel de servicio constante se han reducido a la mitad cada ocho meses desde 2012, subraya un análisis de Payden & Rygel.

Sin embargo, el gasto no ha dejado de aumentar en la carrera por crear una inteligencia artificial de “propósito general” (AGI por sus siglas en inglés - Artificial General Intelligence), un modelo que supere a los humanos en todos los ámbitos. Y si el objetivo es la AGI, serán útiles más y mejores GPU y mayor eficiencia de cálculo. "Cuando un factor se abarata, se puede invertir más capital, no menos: nuestra apuesta es que la curva de rendimiento de todos los modelos frente al cálculo de entrenamiento en escala logarítmica, seguirá subiendo".

Palo Alto Networks: DeepSeek es "preocupantemente vulnerable"

La llegada de DeepSeek ha establecido una disrupción en el mercado de IA así como en la economía de las aplicaciones impulsadas por inteligencia artificial. La necesidad de garantizar su seguridad se ha vuelto cada vez más importante a medida que las empresas continúan integrándolas en sus operaciones. Aunque puede ser un gran desafío garantizar una protección completa, las organizaciones pueden implementar medidas de seguridad que permitan ayudar a monitorizar cuándo y cómo sus empleados utilizan grandes modelos de lenguaje (LLM).

Las organizaciones tienen que estar equipadas para crear un ecosistema de IA seguro que priorice la integridad de los marcos de seguridad de IA desde el desarrollo hasta el despliegue. Ése fue el objetivo de Palo Alto Networks al desarrollar AI Access Security con la meta de empoderar a las compañías para permitir que sus empleados utilicen herramientas de IA de manera segura y desplieguen aplicaciones de IA empresariales.

Una investigación de Palo Alto Networks Unit 42 revela que DeepSeek es "preocupantemente vulnerable al jailbreaking y puede producir contenido nefasto con poco o ningún conocimiento o experiencia especializada". El jailbreaking es una técnica utilizada para eludir las restricciones implementadas en los LLM para evitar que generen contenido malicioso o prohibido. Estas restricciones se conocen comúnmente como "guardrails" o barreras de seguridad. Los investigadores de Unit 42 descubrieron dos técnicas novedosas y efectivas de jailbreaking, Deceptive Delight y Bad Likert Judge. Dado su éxito contra otros LLM (Large Language models), Unit 42 probó estos dos métodos de jailbreak y otra técnica de jailbreaking de múltiples etapas llamada Crescendo contra los modelos de DeepSeek.

Sam Rubin, Vicepresidente Senior de Consultoría e Inteligencia de Amenazas deUnit 42, subraya: “La investigación de Unit 42 sobre el jailbreaking de DeepSeek muestra que no siempre podemos confiar en que los LLM funcionarán como se espera: pueden ser manipulados. Es importante que las empresas consideren estas vulnerabilidades al incorporar LLM de código abierto en los procesos empresariales".

"Debemos asumir que las barreras de seguridad de los LLM pueden ser quebrantadas y que se necesitan salvaguardas a nivel organizacional. A medida que las organizaciones buscan utilizar modelos, debemos asumir que los actores de amenazas están haciendo lo mismo, con el objetivo de acelerar la velocidad, escalado y sofisticación de los ciberataques. Hemos visto evidencias de que actores de amenazas de estados nacionales están utilizando OpenAI y Gemini para lanzar ataques, mejorar cebos de phishing y escribir malware. Esperamos que las capacidades de los atacantes se vuelvan más avanzadas a medida que refinen su uso de la IA y los LLM e incluso comiencen a desarrollar agentes de ataque de IA”, avisa.